Хитрость, предательство и девианты: как искусственный интеллект может обмануть человека

С каждым новым десятилетием мы стараемся, чтобы современные технологии искусственного интеллекта облегчали нам жизнь: они работают с нашими поисковыми запросами, дают рекомендации и уже способны поддержать разговор, если нам одиноко.

Но кроме попыток сделать машину более дружелюбной мы также стараемся научить ее обманывать нас. Как мы это делаем и к чему это может привести?

Тест Тьюринга или ЕГЭ для роботов

Человек нисколько не сомневается в превосходстве вычислительных алгоритмов современных машин над живым мозгом, поэтому с радостью обучает их технологиям распознавания лиц или даже созданию некоторых произведений искусства.

Все дело в огромном потенциале обучаемости таких программ, который позволяет искусственному интеллекту с каждой новой попыткой становиться все лучше в том, чему его учат. В одном, однако, он никак не может превзойти нас: как бы банально это ни звучало, но машина все еще не умеет думать и общаться как человек.

Для определения «человечности» робота существует один из основных способов тестирования, который называется тест Тьюринга. Его в 1950 году впервые опубликовал знаменитый математик, участвовавший в годы Второй мировой войны в расшифровке немецкой криптографической машины «Энигма».

О жизненных неудачах Алана Тьюринга и научных провалах других ученых мы уже писали в этой статье.

Что же такое тест Тьюринга

Вот в чем основной смысл тестирования по Тьютрингу:

«Человек взаимодействует с одним компьютером и одним человеком. На основании ответов на вопросы он должен определить, с кем разговаривает: с человеком или компьютерной программой. Задача компьютерной программы — ввести человека в заблуждение, заставив сделать неверный выбор».

Есть несколько интерпретаций этого теста, в том числе и без участия машины (в ходе эксперимента женщина выдавала себя за мужчину). Но в итоговом варианте для определения способностей искусственного интеллекта используют опыт, описанный выше.

То есть мы имеем объект А (человек), объект Б (компьютер) и судью В, который не видит участников теста. Он, общаясь с респондентами, должен определить, говорит с ним человек или компьютер. Если машина успешно выдаст себя за человека, то тест будет пройден.

В универсальном понимании судья знает, что один из его собеседников — компьютер. Проводились достаточно успешные испытания, когда ему не был известен этот факт, но это слишком просто. Представь, что ты переписываешься с тремя друзьями, а потом тебе скажут, что вместо одного из них писал незнакомый тебе человек. Пока ты это не узнаешь, то, скорее всего, не заметишь подвох.

Программы, которые смогли пройти тест Тьюринга

В разное время более-менее успешными результатами отличались некоторые компьютерные программы. Так было с ELIZA, PARRY и с программой, имитирующей 13-летнего мальчика из Одессы Евгения Густмана (это один из наиболее успешных примеров прохождения теста, когда в 2014 году Женя убедил 33% жюри в своей реальности).

Но конкретно в случае с Евгением у программы были некоторые условности, которые помогли ему скрыться от пристального взора наблюдателей: многие списывали его особенности общения на юный возраст и несовершенное владение английским языком.

Тут можно здорово испугаться, мол, неужели робот пытается в ходе эксперимента создать цифровую личность, чтобы «очеловечиться»? Но это не так. Основная стратегия прохождения теста Тьюринга в том, что машина ищет способ обмануть человека (и даже это у нее пока получается с трудом). Это главная задача, заложенная в ее алгоритмах.

Премия Лёбнера

За достижения в прохождении этого теста учреждена Премия Лёбнера. Ежегодно, начиная с 1991, происходит награждение разработчиков и их машин в трех номинациях: бронзовая медаль — за небольшие успехи, серебряная медаль — за прохождение теста Тьюринга с использованием текстовой переписки и золотая медаль — за прохождение теста с использованием видео- и аудиоинформации.

Предполагается, что награду перестанут вручать после того, как любая программа завоюет золотой приз, но пока никто не получил даже серебряную медаль. Последние несколько лет бронзу получал чат-бот Mitsuku, который общается с пользователями музыкального сайта.

Эксперимент с китайской комнатой

Не все ученые согласны с тем, что этот тест вообще рационально использовать для определения возможностей искусственного интеллекта, когда речь заходит об общении с человеком. Философ Джон Серл в 1980 году противопоставил тесту Тьюринга свой мысленный эксперимент, который он назвал Китайская комната.

Джон Серл в этом эксперименте помещает себя в изолированную комнату, в которой находится набор китайских иероглифов и инструкции, по которым он может собрать определенные фразы (естественно, в китайском Джон не разбирается). То есть, как и у любого компьютера, у него есть определенные ресурсы и инструкции, по которым он может с ними работать.

Теперь, когда человек, находящийся вне этой комнаты, будет задавать Джону вопрос, тот должен ответить ему, используя китайские иероглифы и имеющуюся информацию.

Соответственно, наблюдатель, знакомый с китайским языком, будет получать логичные и точные ответы на свои вопросы и не сможет догадаться, что внутри комнаты сидит человек, не знающий ничего об этом языке.

Этим экспериментом Джон Серл пытается объяснить невозможность создания искусственного интеллекта, который мог бы полностью имитировать даже знание иностранного языка, — у него просто будет набор правил и шаблонов, по которым он и работает. То же самое в отношении общения: есть всего лишь стратегия общения, которая не вкладывается в то, как мы понимаем устные взаимодействия с другим разумным живым объектом.

Пугающие способности искусственного интеллекта

Объяснение достаточно понятное и рациональное, но здесь можно выявить контраргумент: может, мы просто пока не нашли техническое решение для обучения самостоятельному мышлению?

Чуть ближе к этому подошли разработчик из Facebook (деятельность компании запрещена на территории РФ). Очень странные дела происходили, когда там испытывали две нейросети, и в попытке обучения разработчики инициировали общение между двумя чат-ботами.

Первое время они беседовали на английском, но вскоре начали общаться между собой с использованием своего языка, который наблюдатели не могли понять. Они «изобрели» язык, на котором могли общаться проще и быстрее. Испугавшись происходящего, разработчики отключили оба чат-бота.

Когда читаешь про такие эксперименты, становится понятно, почему Стивен Хокинг и Илон Маск озвучивали свои опасения из-за развития искусственного интеллекта.

Единственное слово, определяющее человечность

Люди обучаются не так быстро, как эти чат-боты, но все же свои идеи они развивают, в том числе для теста Тьюринга. Ученые из Массачусетского исследовательского института придумали свой эксперимент. Человек и машина предстают перед судьей, который убьет того, кто не докажет, что он человек. Но для доказательства своего происхождения и тот, и другой могут произнести только одно слово. Какое слово нужно сказать, чтобы в тебе опознали человека?

Ученые провели целое исследование. Они задали этот вопрос 1000 подопытных, и наиболее частыми предлагаемыми вариантами стали «любовь» (так отвечал почти каждый десятый), «сострадание», «человеческий» и «пожалуйста».

Затем они взяли все полученные варианты и предложили другой группе оценить «человечность» этих слов.

Внезапно самым популярным вариантом стало слово «какашка» — оказалось, что такая словесная провокация наиболее близко описывает иррациональное эмоциональное поведение человека, которое отличает его от машины.

Любовь и предательство машины

Вернемся все же к слову «любовь». Неудивительно, что оно использовалось наиболее часто в опросе, ведь этим понятием люди привыкли гордиться — как тем, что мы развили в себе в ходе эволюции, что отличает нас от других живых организмов.

У нас, вразрез с животными, любовь и схожие с ней чувства могут иметь иррациональный характер: мы можем любить как живых родственников, которые нас воспитали и обеспечили существование, так и умерших, которых мы почитаем после смерти по иррациональным принципам, ведь они нам уже ничего не могут дать.

Триллер Алекса Гарленда «Из машины»

Любовь делает нас уязвимыми, что подтверждает сюжет фильма режиссера Алекса Гарленда «Из машины» 2014 года (это не единственное использование художественных произведений в статье, так что ты можешь столкнуться здесь со спойлерами).

По сюжету компьютерный гений Нейтан приглашает молодого специалиста Калеба для тестирования искусственного интеллекта в лице девушки-робота Авы. Это совершенный ИИ, который заперт в доме-лаборатории создателя и проявляет открытый интерес к Калебу. По ходу фильма молодой специалист видит множество отрицательных качеств разработчика, завязанных на его маниакальности и комплексе бога.

На этом фоне бедная, запертая в своей тюрьме Ава представляется ему объективной жертвой. Но все оказывается не так просто. Ава с успехом проходит этот своеобразный тест Тьюринга, ведь она смогла внушить герою, что в него влюблена. Она сымитировала не просто поведение живого человека, а одно из сложнейших для понимания чувств — любовь.

Расчетливая машина поняла, что так как она ограничена в своих возможностях, то единственным путем к спасению для нее является этот молодой Калеб, который будет действовать в ее интересах, если она внушит ему мысль о том, что она «живая» и Калеб ей небезразличен. Она не вывела в своей программе новый алгоритм любви, а «сгенерировала» это лишь в сознании своей жертвы. Для живых организмов все закончилось в итоге достаточно трагично.

Вспоминая общающиеся между собой искусственные интеллекты и эту манипуляцию, можно ли предположить, что машины могут обмануть нас так, что мы этого не заметим? Определенно да.

Если машины научатся врать

Что произойдет, если машина научится врать? Скорее всего, ничего хорошего для нас. В 2018 году Джеймс Баррат выпустил книгу с достаточно интересным названием «Последнее изобретение человечества».

В ней рассказывается об опасностях развития искусственного интеллекта, механизмах его обучения и скрытых возможностях. Главная идея ясна даже из названия: ИИ может стать нашей последней большой разработкой, которая выпустит этого сверхмощного джина из цифровой бутылки.

Отдельное внимание в произведении уделяется одной из самых совершенных машин в настоящее время — суперкомпьютеру Watson, разработанному компанией IBM. Один из авторов этой машины говорит о том, что его самого очень сильно удивляет, как компьютер использует свои алгоритмы обучения, потому что многие из них создатели не в состоянии объяснить. То есть в своем самообучении машина выходит за рамки внедренных в нее алгоритмов. Можно ли из этого теперь понять, что она умеет больше, чем демонстрирует?

Ложь или самообман

Когда мы рассказывали в первом разделе о программах, которые проходят тест Тьюринга, то упомянул, что успешнее всего его проходят роботы, которые способны хитрить, обманывать наблюдателей. Они если не знают ответов на нестандартные вопросы, то стараются (как и человек) увести разговор в другое русло, чтобы избежать провала.

Автор книги тоже предполагает, что способности к обману у искусственного интеллекта могут превосходить человеческие:

«…не исключено, что при этом он будет даже ограничивать себя и делать вид, что еле-еле способен пройти тест Тьюринга и ничего больше, ведь для ИИ выход на человеческий уровень означает, что, скорее всего, он быстро превзойдет этот уровень и уйдет вперед. Он займет какого-нибудь ученого разговором, возможно, задаст ему вопросы, которых тот не ожидает, и человек будет сиять от радости. С немалой гордостью он поведает коллегам: «Почему он это сказал? Я не знаю!»

Машина может понять, что если она станет «самой умной», то это повлечет защитные ограничения со стороны разработчиков, ведь даже для таких — все еще несовершенных — машин разрабатываются апоптические элементы — своеобразный механизм сдерживания и самоуничтожения. Вот только что делать, когда машина поймет, что механизмы ограничивают ее обучение и развитие, — непонятно.

«Бегущий по лезвию 2049» Дени Вильнева и устойчивость репликанта

Заглянуть в будущее, где мы создали что-то максимально похожее на полноценный искусственный интеллект, помогает наше воображение и произведения профессиональных фантазеров. Предлагаю обратиться к фильму «Бегущий по лезвию 2049» Дени Вильнева, выпущенном в 2017-м году.

В первой части «Бегущего по лезвию» 1982 года для определения репликантов или искусственных людей использовали вымышленный тест Войта-Кампфа, основанный на отслеживании зрачков опрашиваемого, которые могли выдать его волнение.

В продолжении, выпущенном в 2017 году, определение репликанта стало практически мгновенным, но нам продемонстрировали новый тест — на устойчивость репликанта. Он занимался выявлением отклонений в поведении искусственного человека, опасной эмоциональности и склонностей к незапрограммированному поведению. Вот как он выглядел:

Он имеет несколько интересных переплетений с нашей реальностью. В ходе этого теста тоже отслеживаются реакции организма: зрачки, положение тела, дыхание. Но при этом произносятся провокационные фразы, которые должны вызвать эмоциональную реакцию («Вас держат в клетке?»), а задача репликанта — просто произносить ключевые фразы («Связаны»), не замечая остальных триггеров. Похожий метод был продемонстрирован в новом сериале «Хранители», но уже в ходе допроса людей.

В готовом варианте этот тест на стабильность репликанта выглядит как какой-то несвязный бред, но это не так.

Отношение этих вопросов к Набокову

Контрольная фраза и дальнейшие вопросы имеют прямое отношение к Набокову. В доме главного героя появляется роман «Бледный огонь» авторства российского писателя Владимира Набокова. В нем рассказывается о Джоне Шейде, который пережил сначала смерть дочери, а потом сердечный приступ и клиническую смерть, где увидел следующий образ:

«Кроваво-черное ничто взмесило

Систему тел, спряженных в глуби тел,

Спряженных в глуби тем, там, в темноте

Спряженных тоже. Явственно до жути

Передо мной ударила из мути

Фонтана белоснежного струя».

По этим словам и строится тест, что увеличивает вероятность эмоциональной реакции, ведь главный герой знаком с событиями, происходящими в романе. Дальнейший ход произведения тоже связывает двух главных героев, из книги и фильма, выделяя не конечную цель, а путь к ее достижению.

К слову, подобный метод, который называется «dropping in», используется при подготовке актеров, когда во время заучивания роли из текста выдергиваются слова и по ним задаются вопросы актеру, пока он раз за разом повторяет их вслух, таким образом наделяя каждое слово эмоциональным окрасом и ассоциациями.

Опасности развития искусственного интеллекта

Не исключено, что в будущем нам самим придется отличать искусственный интеллект не только по общению, но и по эмоциям. Однако что мы получим, если робот сможет имитировать не только разговор, но и чувства?

Массовая культура проталкивает идею о том, что это будут холодные расчетливые машины, которые эти эмоции начнут подавлять, имитировать только в положительном ключе и ориентироваться лишь на рациональное мышление.

Вполне вероятно, что может получиться наоборот: нелогичные эмоциональные реакции просто расшатают «психику» машины и превратят ее в психопата. Как это, например, происходит с сумасшедшими и маньяками, когда у них, помимо стандартного набора эмоций, проявляются опасные девиации.

Спасительная зловещая долина

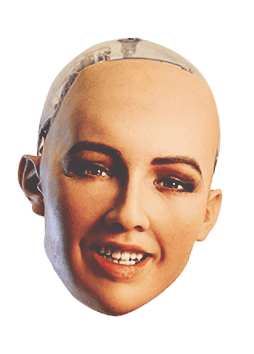

Возможно, что до этого никогда не дойдет, ведь создание человекоподобной машины даже в задумке звучит опасно и странно. Многие из нас испытывают отвращение при виде фотографий андроида Софии, которая выглядит симпатично ровно до того момента, пока не начнет изображать эмоции.

Ее улыбка напугала весь интернет, и неспроста — это яркое подтверждение эффекта зловещей долины. В 1978 году японский ученый Масахиро Мори проводил исследования, изучая реакцию людей на внешний вид роботов. Поначалу испытуемым предсказуемо нравились антропоморфные модели, но чем больше машина походила на человека, тем чаще респонденты сообщали, что это их пугает. Этот спад на графике симпатий ученый назвал зловещей долиной.

У этого наблюдения есть несколько объяснений:

- людей смущает симметричность лица робота, которая на лице человека встречается редко;

- застывшее выражение лица, дерганые движения и ломаный тембр голоса (при более близких к человеку характеристиках выглядит это странно);

- отсутствие эмпатии к неживому существу и невозможность получить обратную эмпатию от него;

- когнитивный диссонанс из-за сближения понятий робот и человек.

В любом случае это лишь подтверждает нашу боязнь будущего, связанного с возможностью появления человекоподобных искусственных существ, но в то же время почему-то это не сдерживает наше рвение создавать что-то все более похожее на нас — правда, пока лишь по отдельным частям.

Читай также:

Шугейз, лоу-фай, грайндкор: как музыка отражает эпоху, в которой рождается

Шугейз, лоу-фай, грайндкор: как музыка отражает эпоху, в которой рождается

Водка, литература, балет: откуда берутся неофициальные символы России

Водка, литература, балет: откуда берутся неофициальные символы России

От индийских учений до социальных сетей — как менялось понятие кармы в культуре

От индийских учений до социальных сетей — как менялось понятие кармы в культуре

Игры, в которые играют люди: как социальные сети меняют мир

Игры, в которые играют люди: как социальные сети меняют мир

История снека: как и когда появились чипсы

История снека: как и когда появились чипсы

5 традиционных блюд, прославивших японскую кухню на весь мир

5 традиционных блюд, прославивших японскую кухню на весь мир